En los últimos años, el mundo de la telefonía móvil ha experimentado enormes cambios. Podemos ver diferencias fundamentales en prácticamente todos los aspectos, independientemente de si nos centramos en el tamaño o en el diseño, el rendimiento u otras funciones inteligentes. La calidad de las cámaras juega actualmente un papel relativamente importante. De momento, podríamos decir que este es uno de los aspectos más importantes de los smartphones, en el que los buques insignia compiten constantemente. Además, cuando comparamos, por ejemplo, los teléfonos Android con el iPhone de Apple, encontramos una serie de diferencias interesantes.

Podría ser te interesa

Si estás interesado en el mundo de la tecnología móvil, seguro que sabes que una de las mayores diferencias la podemos encontrar en el caso de la resolución de los sensores. Mientras que los Android suelen ofrecer una lente de más de 50 Mpx, el iPhone lleva años apostando por sólo 12 Mpx, y aún puede ofrecer fotografías de mejor calidad. Sin embargo, no se presta mucha atención a los sistemas de enfoque de imágenes, donde encontramos una diferencia bastante interesante. Los teléfonos de la competencia con sistema operativo Android suelen confiar (parcialmente) en el llamado enfoque automático por láser, mientras que los teléfonos inteligentes con el logotipo de la manzana mordida no disponen de esta tecnología. ¿Cómo funciona realmente, por qué se utiliza y en qué tecnologías confía Apple?

Enfoque láser vs iPhone

La tecnología de enfoque láser mencionada funciona de forma bastante sencilla y su uso tiene mucho sentido. En este caso, en el módulo fotográfico hay un diodo oculto que emite radiación cuando se presiona el gatillo. En este caso, se envía un rayo que rebota en el sujeto/objeto fotografiado y regresa, tiempo que se puede utilizar para calcular rápidamente la distancia mediante algoritmos de software. Desgraciadamente, también tiene su lado oscuro. Al tomar fotografías a distancias mayores, el enfoque del láser ya no es tan preciso o al tomar fotografías de objetos transparentes y obstáculos desfavorables que no pueden reflejar de manera confiable el rayo. Por esta razón, la mayoría de los teléfonos todavía dependen del algoritmo probado para detectar el contraste de la escena. Un sensor con tales puede encontrar la imagen perfecta. La combinación funciona muy bien y garantiza un enfoque de imagen rápido y preciso. Por ejemplo, el popular Google Pixel 6 cuenta con este sistema (LDAF).

Por otro lado, tenemos el iPhone, que funciona un poco diferente. Pero en el fondo es bastante similar. Cuando se presiona el gatillo, el componente ISP o Procesador de Señal de Imagen, que se ha mejorado significativamente en los últimos años, juega un papel clave. Este chip puede utilizar el método de contraste y algoritmos sofisticados para evaluar instantáneamente el mejor enfoque y tomar una fotografía de alta calidad. Por supuesto, según los datos obtenidos, es necesario mover mecánicamente la lente a la posición deseada, pero todas las cámaras de los teléfonos móviles funcionan de la misma forma. Aunque están controlados por un "motor", su movimiento no es giratorio, sino lineal.

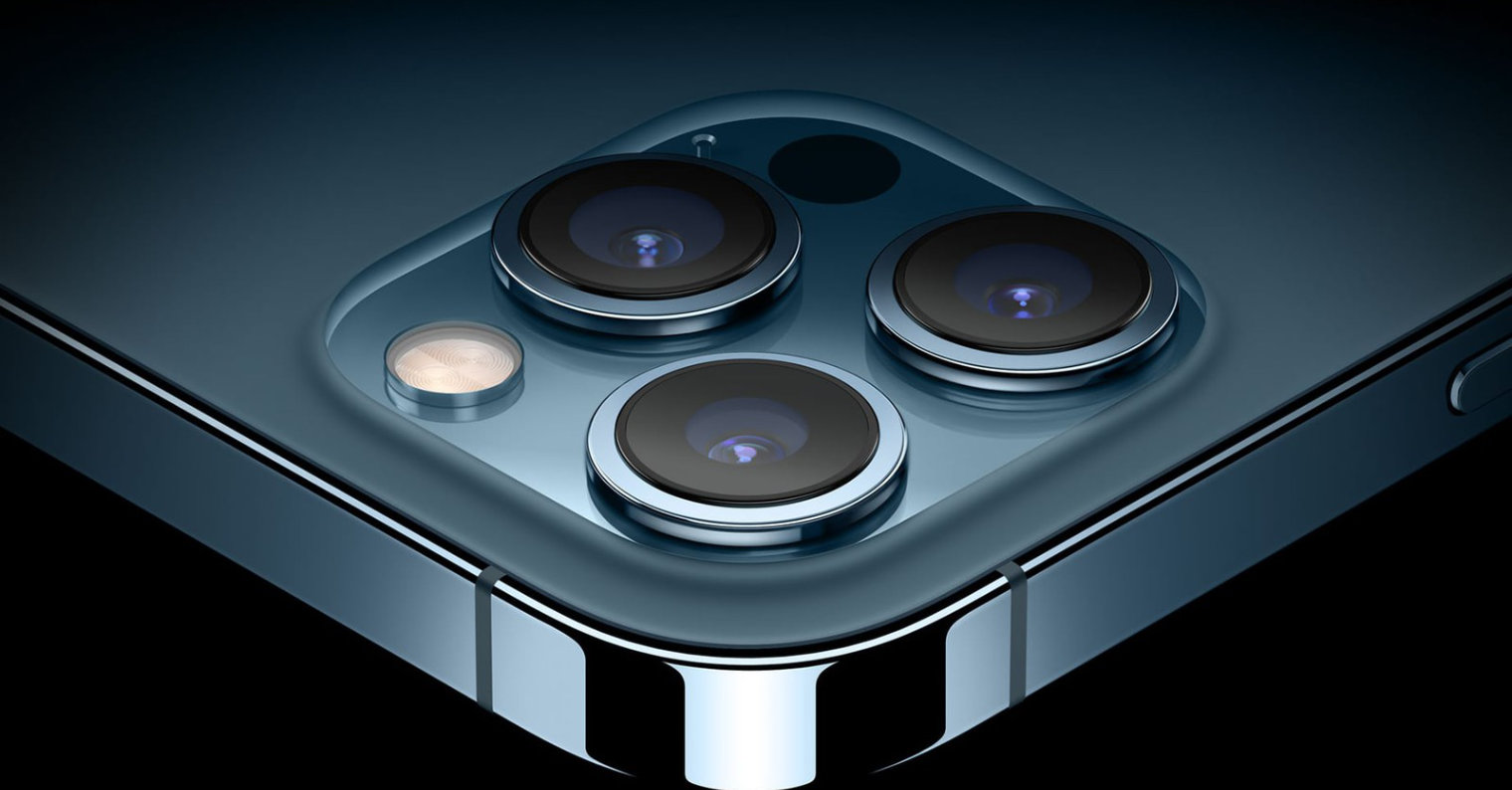

Un paso por delante están los modelos iPhone 12 Pro (Max) y iPhone 13 Pro (Max). Como habrás adivinado, estos modelos están equipados con el llamado escáner LiDAR, que puede determinar instantáneamente la distancia al sujeto fotografiado y aprovechar este conocimiento. De hecho, esta tecnología se acerca al mencionado enfoque láser. LiDAR puede utilizar rayos láser para crear un modelo 3D de su entorno, por lo que se utiliza principalmente para escanear habitaciones, en vehículos autónomos y para tomar fotografías, principalmente retratos.

Podría ser te interesa

adam kos

adam kos

Volando alrededor del mundo con Apple

Volando alrededor del mundo con Apple