Apple no podía esperar. Aunque tiene prevista su Keynote inaugural de la WWDC para principios de junio, el campo de la IA avanza cada día, por lo que probablemente no quería perder más tiempo. En forma de nota de prensa, describió lo que será capaz de hacer su inteligencia artificial en iOS 17 y le añadió otras funciones que giran en torno a la Accesibilidad. Hay mucho, las funciones son interesantes, pero hay dudas sobre la usabilidad masiva.

Podría ser te interesa

El anuncio de noticias también fue respaldado por el Día Mundial de la Accesibilidad, que se celebra el jueves, porque las funciones recientemente introducidas giran en torno a la accesibilidad de los iPhones de la A a la Z. La accesibilidad es un gran bloque de funciones del iPhone cuyo objetivo es ayudar a controlarlo en todo momento. diferentes formas de discapacidad, aunque muchas de ellas por supuesto, todo el mundo puede utilizarlas, lo que también se aplica a las novedades que veremos en iOS 17. Sin embargo, no todas, como Assistive Access, están basadas 100% en IA.

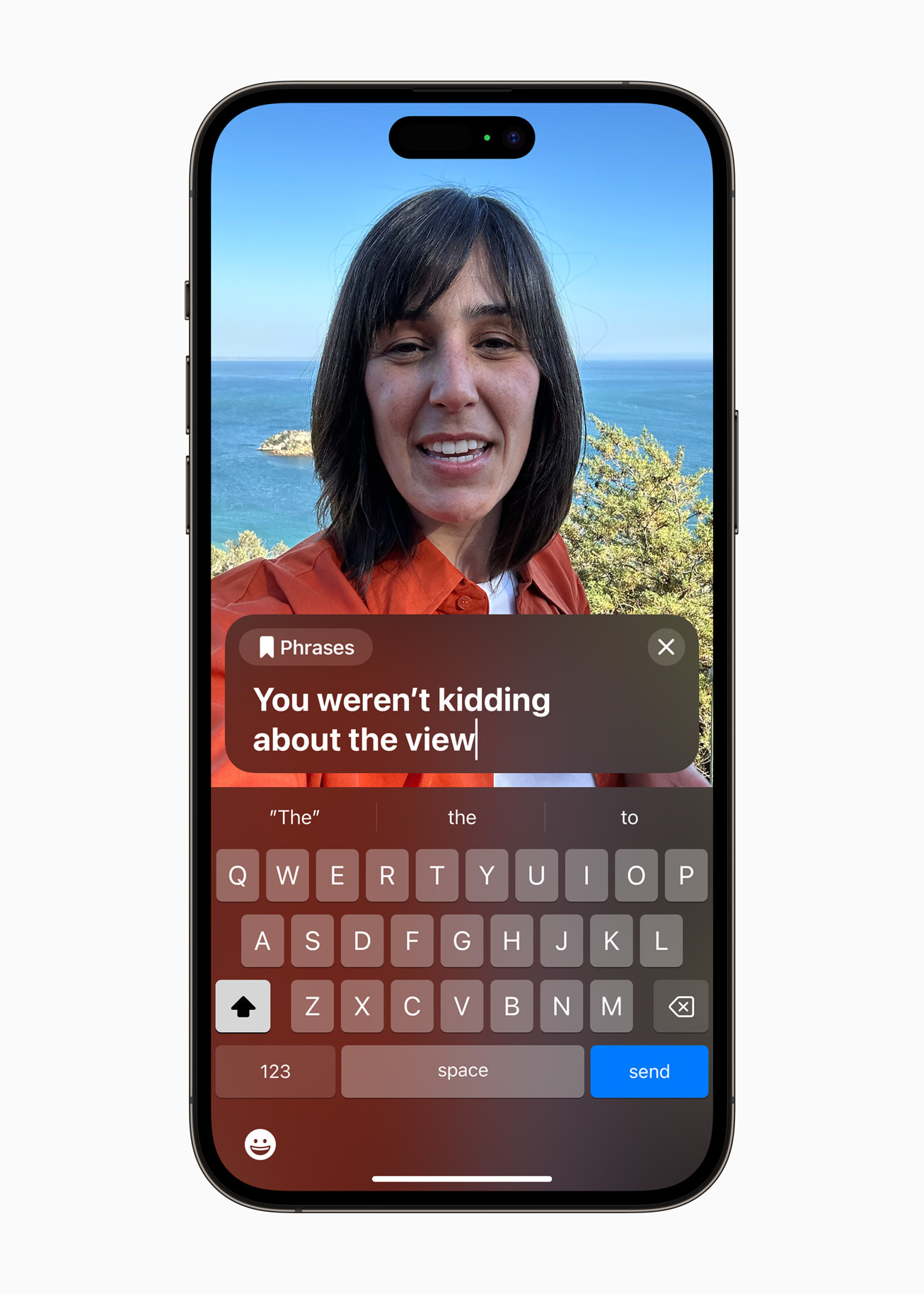

discurso en vivo

Lo que escribas en la pantalla del iPhone se leerá en el otro lado. Debería funcionar localmente, aunque también debería funcionar en una llamada telefónica. La función podrá funcionar en tiempo real, pero al mismo tiempo ofrecerá frases preestablecidas para que la comunicación no solo sea la más fácil, sino también la más rápida, cuando no será necesario anotar las conexiones utilizadas con frecuencia. Existe una gran duda sobre la disponibilidad, es decir, si funcionará también en checo. Eso esperamos, pero no lo creemos demasiado. Lo cual, al fin y al cabo, también se aplica a otras noticias.

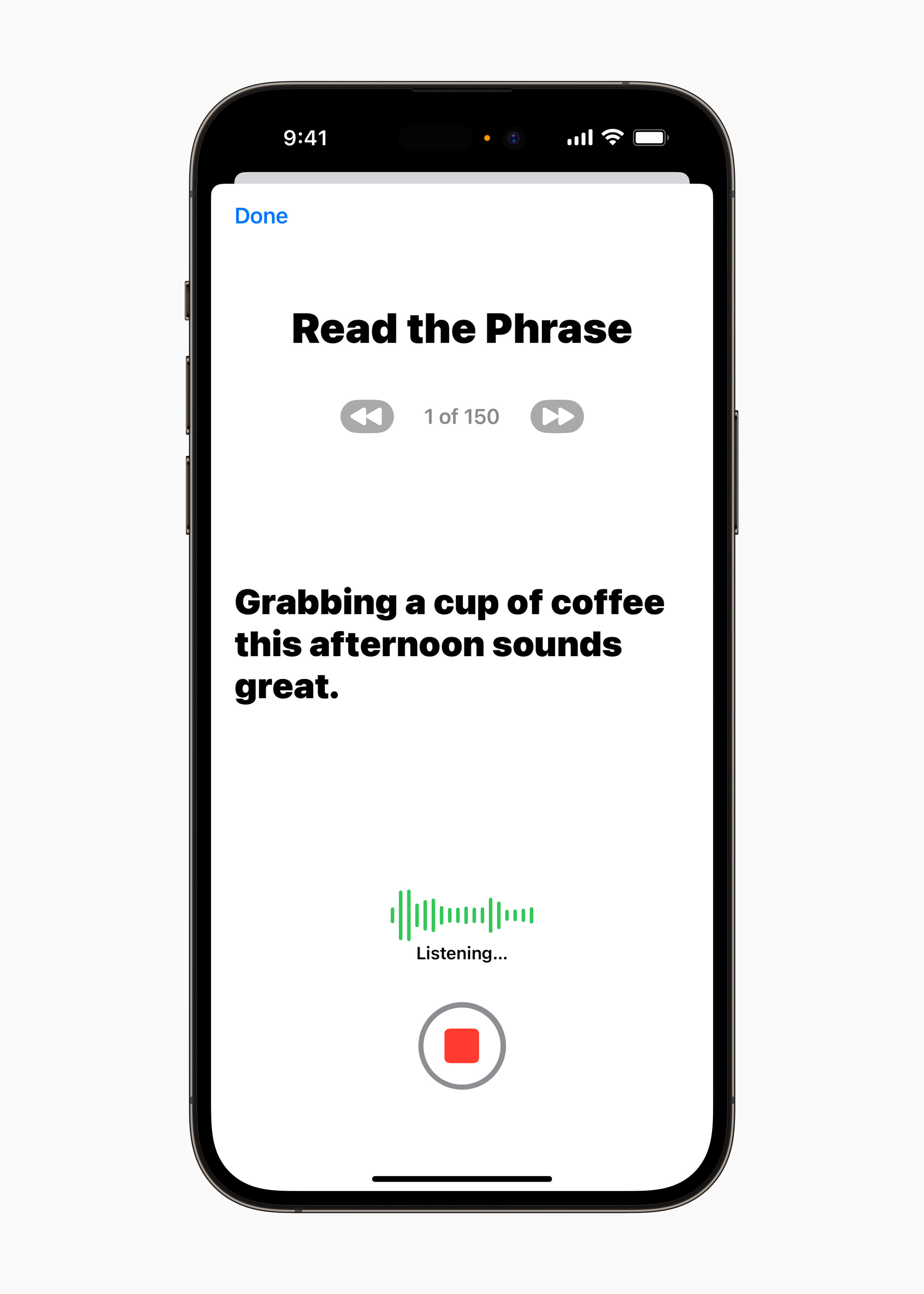

Voz personal

Siguiendo a la innovación anterior, también existe una función asociada a la voz y al habla, que, hay que decirlo, todavía no tiene paralelo. Con la función Personal Voice, los iPhone podrán crear una copia exacta de tu propia voz, que podrás utilizar en el caso del punto anterior. El texto no será leído por una voz unificada, sino por la tuya. Con la excepción de las llamadas telefónicas, esto, por supuesto, también se puede utilizar en mensajes de audio de iMessage, etc. La creación completa de su voz requerirá de IA y aprendizaje automático no más de 15 minutos, durante los cuales leerá el texto presentado y otros textos. indicaciones. Luego, si por alguna razón pierdes la voz, se guardará en tu iPhone y aún podrás hablar con ella. No debería ser un riesgo para la seguridad, porque todo sucede localmente.

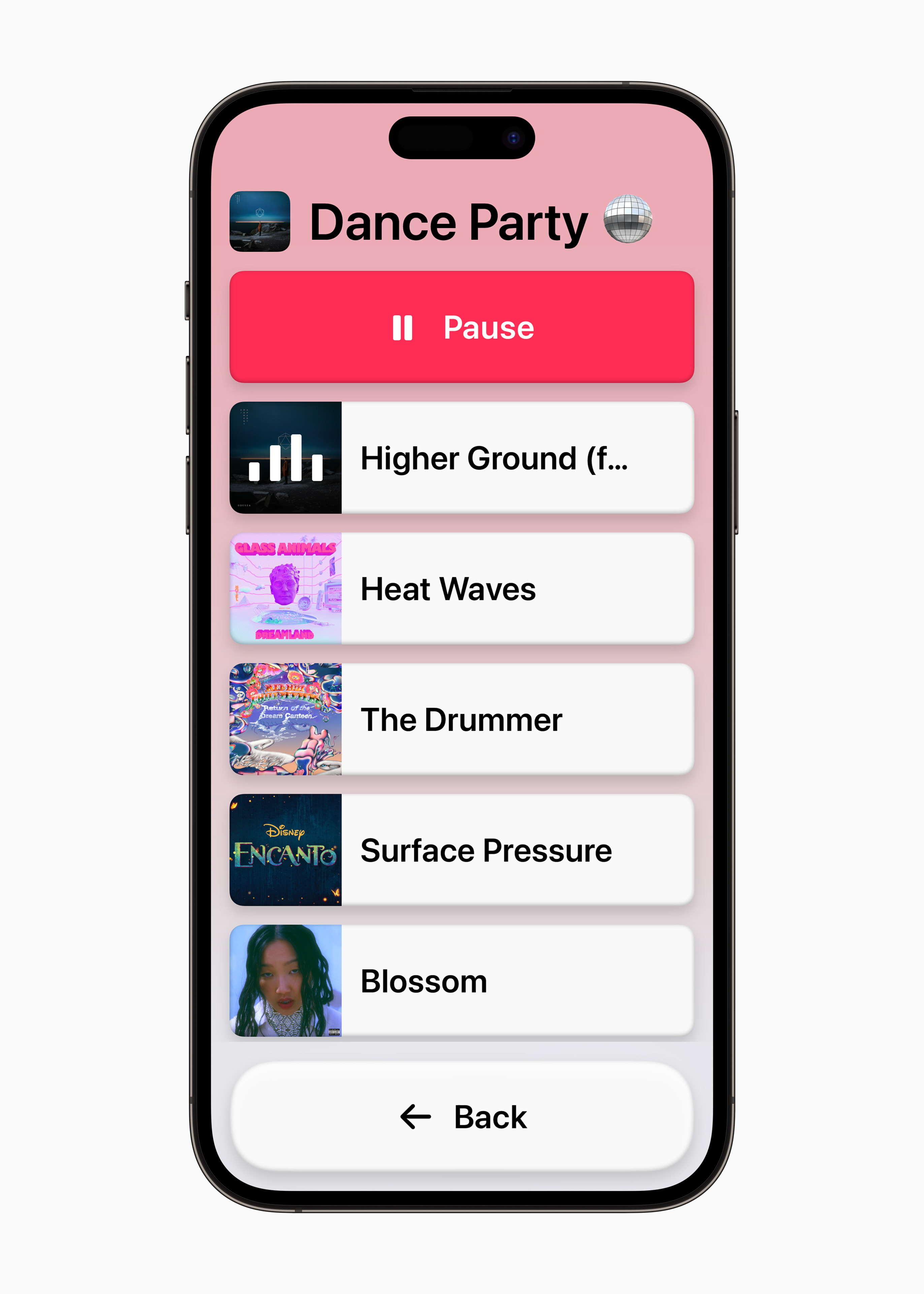

Enfoque de asistencia

En el mundo de los dispositivos Android, el modo senior es algo bastante común. Además, también es muy fácil de usar, al fin y al cabo, igual que el que ajusta la interfaz para los más pequeños. En el caso de los iPhone, lo primero mencionado se viene especulando desde hace tiempo, pero ahora Apple por fin lo ha desvelado. Al activarlo, el entorno se simplificará en general, cuando, por ejemplo, se unificarán aplicaciones como Phone y FaceTime, los iconos serán más grandes y también habrá personalizaciones, gracias a las cuales la interfaz se configurará exactamente de acuerdo con las necesidades del usuario (puedes poner una lista en lugar de una cuadrícula, etc.).

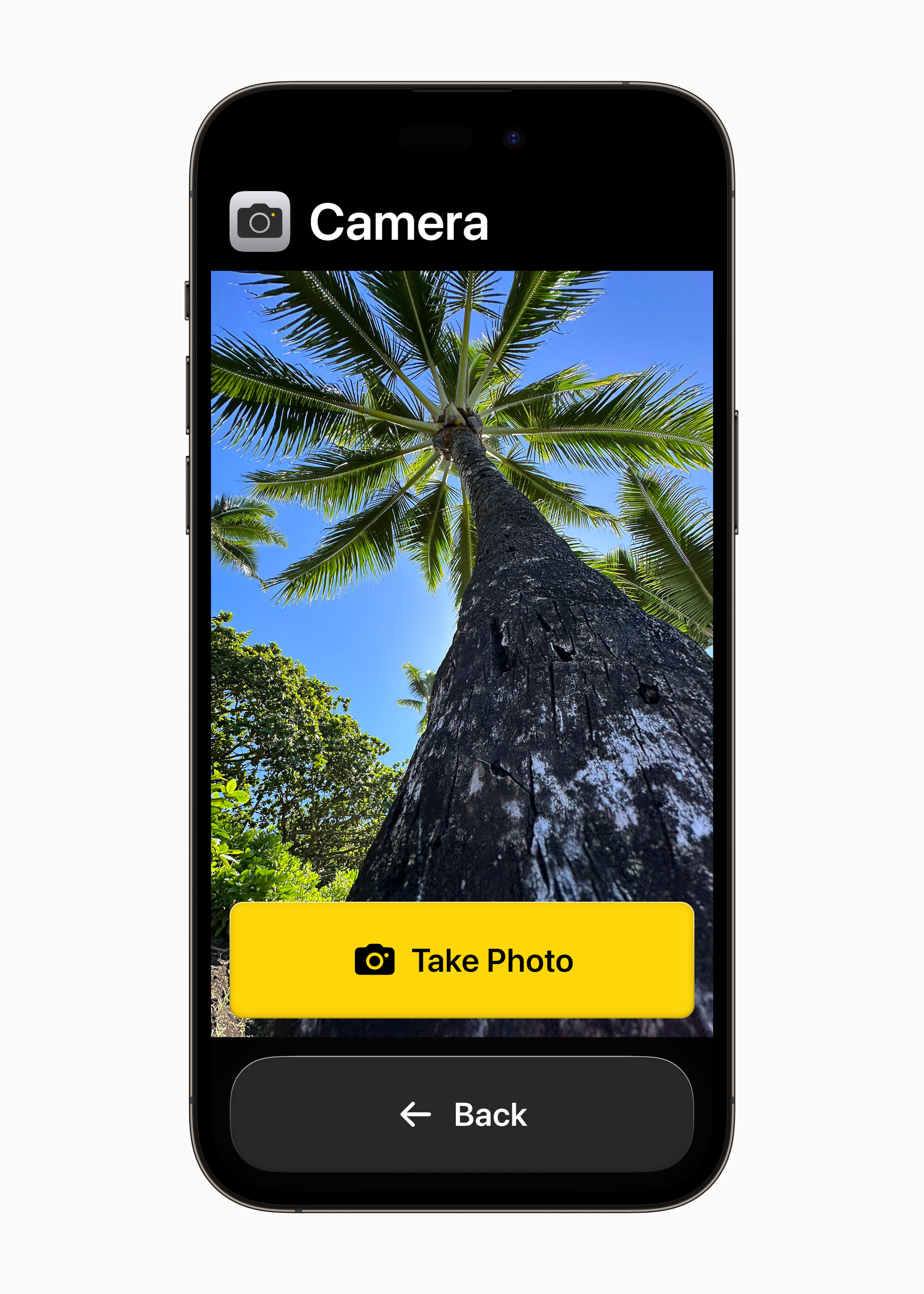

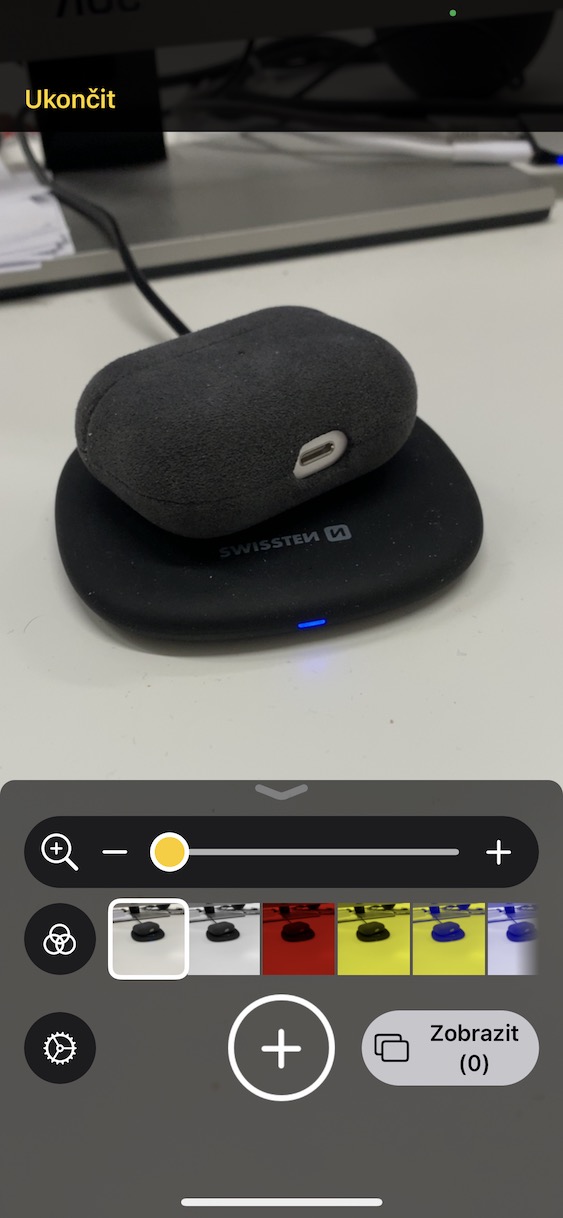

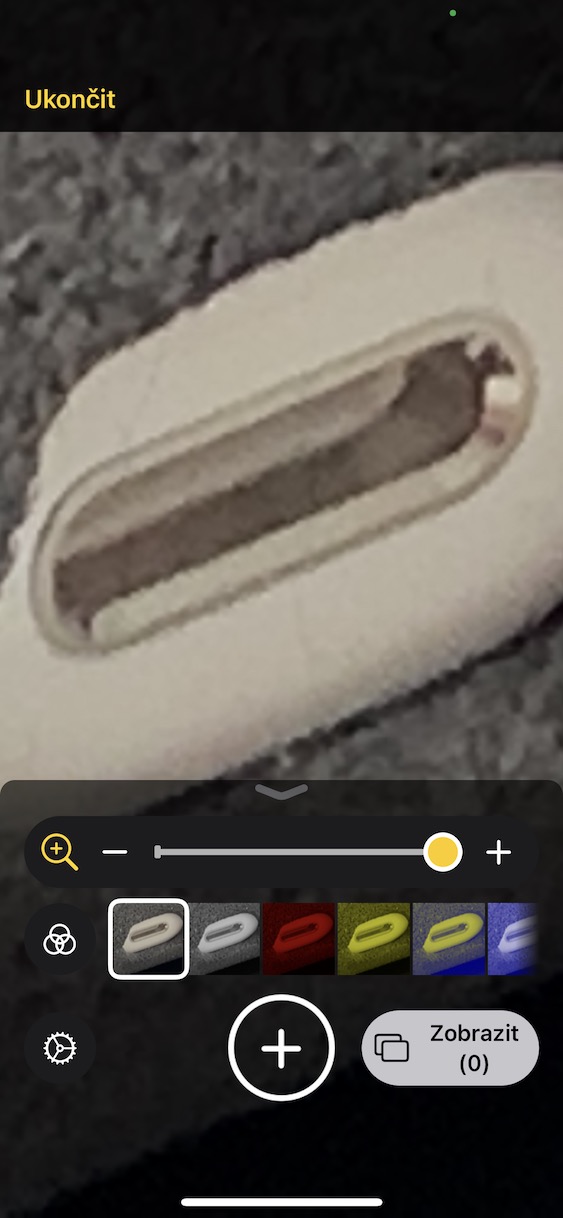

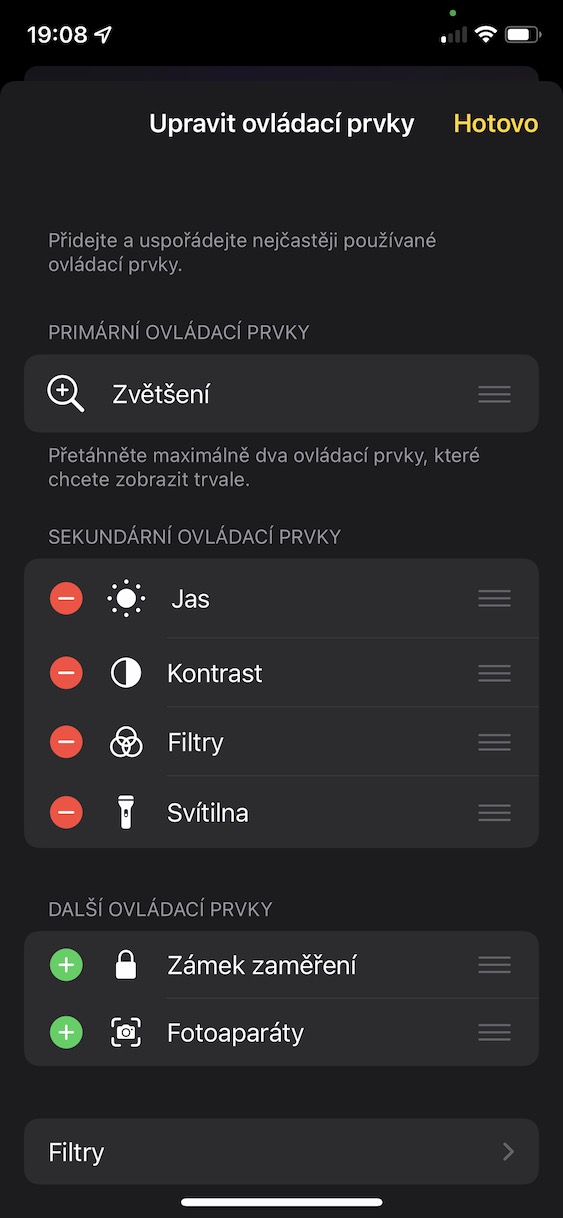

Modo de detección de función de lupa

Si alguien sufre una discapacidad visual, Apple intentará hacerle la vida más fácil utilizando la función Lupa, que utiliza aprendizaje automático e inteligencia artificial para intentar reconocer a qué apunta el usuario del teléfono a través del visor de la cámara. La función debería entonces reconocerlo correctamente y comunicárselo al usuario por voz. Después de todo, hay bastantes aplicaciones sobre este tema en la App Store, son bastante populares y realmente funcionales, por lo que está claro de dónde sacó Apple su inspiración. Pero Apple lleva esto aún más lejos en el caso de apuntar directamente, es decir, eso sí, con el dedo. Esto es útil, por ejemplo, con varios botones de los electrodomésticos, cuando el usuario sabe claramente qué dedo tiene y si debe presionarlo. Sin embargo, la lupa también debería poder reconocer personas, animales y muchas otras cosas, algo que, al fin y al cabo, también puede hacer Google Lens.

Más noticias Accesibilidad

Se publicó otra línea de funciones entre las que cabe destacar dos en particular. La primera es la capacidad de pausar imágenes con elementos en movimiento, normalmente GIF, en Mensajes y Safari. Después de eso, se trata de la velocidad de habla de Siri, que podrás limitar de 0,8 al doble de velocidad.

Podría ser te interesa

adam kos

adam kos